S• 5.1 • Analíticas del aprendizaje: investigación básica, tipos y aplicaciones •

"Las instituciones y corporaciones de aprendizaje hacen poco uso de la información que los estudiantes "desechan" en el proceso de acceso a materiales de aprendizaje, interactuando con educadores y compañeros, y creando nuevo contenido. En una época donde las instituciones educativas están en creciente presión para reducir costos y aumentar eficiencia, la analítica promete ser un lente importante a través del cual ver y planificar cambios en el curso y niveles de instituciones."Conference Learning Analytics and Knowledge

Un poco de historia

La cita con que abre esta lección es tomada de la primera conferencia LAK11 (Learning Analytics and Knowledge 2011). El énfasis en la oportunidad dada por la recolección de datos abría en aquel entonces una puerta para la generación de un área de investigación dedicada a considerar la conexión entre los datos trazados en entornos digitales de aprendizaje y retroalimentación continua al docente, para informar su toma de decisiones, así como al estudiante, para apoyarlo en la (auto) regulación de aprendizajes.

Siemens (2007) fue uno de los pioneros en la definición de un naciente campo de estudio, el de las analíticas de aprendizaje (de analíticas), de la mano de su trabajo en MOOC. Junto a Gasevic (otro investigador cuya contribución veremos más adelante que será muy relevante en el sector) definían las de analíticas como:

(…) la medición, recopilación, análisis e informe basado en datos sobre los estudiantes y sus contextos, con el fin de comprender y optimizar el aprendizaje y los entornos en los que se produce” (Siemens & Gasevic, (2012), p. 1)

Siguiendo ese trend, la Open University en el Reino Unido, una gran universidad que opera completamente en línea, produjo las primeras experimentaciones, generó un grupo de trabajo que lideró el desarrollo del campo y más tarde produjo también una crítica (Herodotou et al., 2019; Knight et al., 2014; Rienties et al., 2016). Rebecca Ferguson, del mismo grupo, generó una visión sobre la complejidad del campo donde a la recogida de datos se unía una visión compleja de las posibilidades de investigación pedagógica sobre los mismos datos (Ferguson, 2012). Este grupo de autores es también el que va a enfatizar que el trazado de datos debe ir mucho más allá de las plataformas eLearning para abarcar la interoperabilidad con otros sistemas y dar una base sólida a los constructos pedagógicos adoptados (Knight et al., 2014; Herodotou et al., 2019). Ya indicadas en el trabajo seminal de Long & Siemens (2011) a partir de la evolución de los temas dentro de la conferencia LAK (Baker et. al, 2021), se iban dividiendo también las áreas de investigación en la educación superior, relacionadas con:

- Eficacia de sistema (prevención del abandono)

- Apoyo de las decisiones docentes (prevenir fracaso, focalizar atención, orientar estudio de profundización, etc.)

- Apoyo de la autonomía de estudio o “autorregulación”.

Así mismo, generaba una definición de las tipologías de analíticas según el tipo de tecnología de trazado de datos y de operaciones algorítmicas llevados a cabo, como indicado en la tabla 1.

ENFOQUES DE PROCESAMIENTO DE DATOS TIPOLOGÍA DE ANALÍTICA

Registro de eventos presentes, análisis ex-post | Analíticas Descriptivas

Registro de eventos presentes, análisis ex-ante | Analíticas de Diagnóstico

Registro de eventos pasados, probabilidad posterior | Analíticas Predictivas

Registro de eventos pasados, modelización y recomendación | Analíticas Prescriptivas

Tabla 1

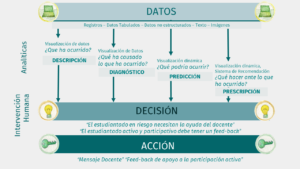

La figura 2 expande la definición por tipologías mostrando los niveles de automatización y su relación con la intervención humana en los procesos pedagógicos mediados por analíticas de aprendizaje.

Es importante comprender que se asume frecuentemente una total automatización de procesos, pero en realidad, hay una gran dependencia de la acción humana en la interacción con sistemas de analíticas. Más aún, es deseable que el docente comprenda dichos niveles de interacción como una suerte de “trabajo de equipo post-humano” en el que los niveles de automatización no compiten con la acción humana sino que la apoyan.

El interés por las de analíticas creció incesamente desde dichos albores, por una parte, debido al interés de la comunidad de investigación interdisciplinar entre educación y ciencia computacional. El crecimiento se asociaba a las posibilidades aplicativas y en particular de negocio que se entreveran en el trazado de datos, sin embargo, con las varias experimentaciones los investigadores y desarrolladores se dieron cuenta de varios “baches” que impedían el uso de muchas de analíticas desarrolladas o inclusive las hacían poco fiables. Ello sentaba las bases para un trabajo de crítica socio-técnica respecto de las de analíticas. Dicho debate desarrollaba ya a partir del 2014, con la contribución de algunos autores como Paul Prinsloo y Sharon Slade de Sudáfrica (Prinsloo, 2017; Slade & Prinsloo, 2013) y el mismo Dragan Gasevic (Tsai & Gasevic, 2017) a partir de su tarea en el Centro de Investigación de Cultura Digital de la Universidad de Edimburgo, que desde siempre ha mantenido un enfoque socio-crítico a las tecnologías digitales. Es en esta coyuntura que se va a abrir un debate sobre la calidad de las de analíticas, que hasta el 2015 no habría tenido lugar.

Un elemento central para comprender de dónde emergen las “dificultades” en la caracterización de los sistemas de analíticas reside en la complejidad intrínseca de las arquitecturas de datos necesarias para generar representaciones (analíticas diagnósticas) y sistemas de recomendación (sistemas prescriptivos) que resulten útiles, usables y fundamentalmente relevantes para las y los usuarios.

Un elemento central para comprender de dónde emergen las “dificultades” en la caracterización de los sistemas de analíticas reside en la complejidad intrínseca de las arquitecturas de datos necesarias para generar representaciones (analíticas diagnósticas) y sistemas de recomendación (sistemas prescriptivos) que resulten útiles, usables y fundamentalmente relevantes para las y los usuarios.

A través de las ilustraciones que presentamos a continuación (Figuras 2,3,4), un elemento central a focalizar es que todas las de analíticas se basan en un concepto pedagógico, que es un constructo teórico o complejo, cuya fenomenología se “traza” a partir de datos asociados a la misma. Por ejemplo, un indicador de “potencialidad de abandono”, puede ser el menor tiempo transcurrido en una plataforma de aprendizaje (ejemplo banal, con el fin ilustrativo).

La Figura 2 muestra algunas de las fuentes de datos que pueden llegar a alimentar un sistema de de analíticas.

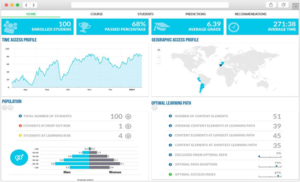

Las Figuras 3 y 4 muestran un par de ejemplos de panel de analíticas de aprendizaje (como plugins de Moodle o proyectos experimentales).

• Para profundizar •

Según Williamson (2016, p. 401)

La ciencia de datos educativos es un campo emergente y transdisciplinario, que se basa tanto en las prácticas científicas de datos como en los conocimientos existentes de las ciencias del aprendizaje (una combinación de ciencias psicológicas, cognitivas y neurológicas).

• La lección en pocas palabras •

- Los datos digitales recogidos en ámbitos educativos buscan generar diagnósticos y sistemas de recomendaciones (o prescripciones) para orientar el comportamiento del profesorado y el estudiantado en base a una “concepción” pedagógica subyacente parte de quién diseña el sistema.

- Esa concepción no siempre es visible, transparente o compartida.

- Recordemos que cuantas más fuentes de datos se usan, más oportunidades de entrenamiento tendrán los algoritmos y mayores serán las posibilidades de operacionalizar correctamente constructos complejos de aprendizaje como “riesgo de abandono de un curso”

- Los “dashboards” o paneles de visualización son el resultado final de la elaboración y tratamiento de datos digitales y buscan influir en el comportamiento del usuario (docente o estudiante).